Методы обработки данных наблюдений — Энциклопедия по экономике

Методы обработки данных наблюдений [c.109]Изучение затрат рабочего времени независимо от метода и вида наблюдений организуется по следующим этапам подготовка к наблюдению проведение наблюдений обработка данных наблюдений анализ результатов обработки разработка норм труда и предложений по совершенствованию организации труда. [c.60]

Метод моментных наблюдений относится к методам групповой несплошной фотографии рабочего времени, осуществляемой специальным наблюдателем. При этом методе наблюдатель через установленные интервалы записывает, чем заняты рабочие в данный момент. Преимуществом этого метода являются его простота и возможность в короткий срок при работе одного наблюдателя получить данные о затратах рабочего времени большого числа одновременно работающих исполнителей. Моментные наблюдения проводят, как и фотографию рабочего времени, в три этапа подготовительный, процесс наблюдения и обработка данных наблюдения.

Оперативный анализ, проводимый по ходу производства, возможен на всех уровнях управления. Особенность оформления его результатов связана прежде всего с механизацией или автоматизацией учета и контроля и внедрением оперативных методов обработки данных. В первичных звеньях оперативный анализ проводится углубленно, по всем объектам и по кругу показателен, которые претерпевают постоянные изменения. В вышестоящих органах оперативный анализ, как правило, не носит сквозного характера. Он базируется на выборочных наблюдениях и имеет характер экспресс-анализа, т. е. быстрой проработки выборочных данных с целью улавливания тенденций нх изменения. Выводы оперативного анализа чаще всего оформляются в виде конкретных сигналов, направленных непосредственным исполнителям для корректировки их деятельности. [c.128]

Лабораторный метод основан на наблюдениях, производимых в специально созданных условиях в лабораториях. Порядок замеров, обработки данных наблюдений и проектирование норм те же, что и при производственном методе нормирования расхода строительных материалов.

После получения необходимого количества замеров проводится обработка данных наблюдений. Для каждого элемента операции получают ряд значений его продолжительности, т.е. хронометражный ряд. Первым этапом его обработки является исключение дефектных замеров, которые выявляются прежде всего на основе записей в наблюдательном листе об отклонениях от нормального режима работы. Затем проводится анализ хроноряда. Обычно для этого используются фактические коэффициенты устойчивости, рассчитываемые по формуле (7.2.1). Их значения сравниваются с нормативными (табл. 7.2.1). Если фактический К не больше нормативного, то хроноряд считается устойчивым, в противном случае рекомендуется исключить максимальное значение продолжительности элементов операции, а затем вновь рассчитать К. Следует отметить, что исключение дефектных замеров на основе коэффициентов устойчивости нельзя считать достаточно обоснованным.

Параметр модели — это относительно постоянная величина, включаемая в модель и рассматриваемая как свойство объекта моделирования. В свою очередь, значения параметров модели являются результатом обработки данных, полученных в процессе эксперимента или наблюдения, с помощью различных статистических методов (наименьших квадратов, максимального правдоподобия и др.). Для моделирования параметры выступают как выбираемые значения. Среди параметров выделяются такие, которые изменяют содержание модели, так называемые управляющие параметры. [c.429]

Обработка результатов замеров времени Использовать математические методы обработки результатов замеров времени с применением ЭВМ и элементами математической статистики При определении норм времени и выработки учитывать действие факторов технического переоснащения оборудования, квалификацию работников производства, занятых данной технологической операцией Листы наблюдений после предварительной обработки инженерами-нормировщиками передаются в ИВЦ для их обработки Создать в ИВЦ массив НСИ по трудоемкости технологических операций. Результаты обследования обрабатываются в ИВЦ. Результатом обработки являются варианты норм времени и выработки в конкретных условиях производства

[c.280]

Результаты обследования обрабатываются в ИВЦ. Результатом обработки являются варианты норм времени и выработки в конкретных условиях производства

[c.280]

Все методы исследования затрат рабочего времени включают следующие основные этапы подготовка к наблюдению, его проведение, обработка данных, анализ результатов и подготовка организационно-технических предложений в соответствии с целью проводимых наблюдений. Содержание работ по каждому этапу зависит от метода исследования затрат рабочего времени. [c.315]

СТАТИСТИКА ЦЕН —отрасль статистики, в задачи к-рой входит сбор и обработка данных о ценах, ценообразовании и тарифах. Методы статистич. анализа применяются с целью изучения цен и тарифов в их взаимосвязи, выяснения их влияния на выполнение производственного плана, уровень себестоимости и рентабельности предприятий, на доходы государственного бюджета, развитие товарооборота и улучшение ассортимента товаров. Большое значение имеет С. ц. для изучения роли цены в исчислении объемов валовой и товарной продукции, товарооборота, в распределении общественного продукта и национального дохода.

В первой главе рассматриваются задачи и организация статистики и экономического анализа в стране. Две последующие главы, посвященные изложению основ теории сбора данных, их сводки и группировки и простейших методов анализа, позволяют слушателям правильно использовать результаты статистического наблюдения и обработки данных, овладеть важнейшими приемами работы с цифрами. Здесь даются также понятия методов выборочного наблюдения, анализа вариации и связи. [c.4]

Методы принятия решений в условиях риска разрабатываются и обосновываются также и в рамках так называемой теории статистических решений. Теория статистических решений является теорией проведения статистических наблюдений, обработки этих наблюдений и их использования. Как известно, задачей экономического исследования является уяснение природы экономического объекта, раскрытие механизма взаимосвязи между важнейшими его переменными.

На предприятиях широко распространена самофотография рабочего времени. При определенной предварительной подготовке этот метод позволяет охватить наблюдением практически все предприятие и за короткий срок (два-три дня с обработкой данных) получить информацию об основных потерях рабочего времени. Пользуясь этим методом, рабочий (работник), не отвлекаясь от основной работы, отмечает [c.20]

Для определения норм труда вспомогательных рабочих чаще всего используют косвенные методы, с помощью которых устанавливают нормы труда не по трудоемкости конкретных работ в конкретных условиях, а по факторам, косвенно влияющим на затраты труда соответствующей группы рабочих. Зависимость нормы труда от этих факторов определяют путем статистической обработки данных планово-учетной документации и результатов наблюдений по группе представителей цехов (участков) различных предприятий.

[c.249]

Зависимость нормы труда от этих факторов определяют путем статистической обработки данных планово-учетной документации и результатов наблюдений по группе представителей цехов (участков) различных предприятий.

[c.249]

В отличие от затрат времени по основным производственным работам, результаты наблюдений по которым обрабатывают, как правило, графоаналитическим методом, при обработке материалов наблюдений и данных оперативного и технического учета о затратах рабочего времени по обслуживающим процессам для вывода эмпирических зависимостей чаще применяют корреляционный анализ. [c.145]

При исследовании социально-экономической структуры народного хозяйства и социалистического общества в целом экономическая статистика базируется на основных положениях общей теории статистики и методах ее. В этой связи необходимо выделить статистическое наблюдение, программу и научную организацию его методы обработки и сводки массовых данных, полученных в результате реализации соответствующей программы наблюдения методы анализа научно разработанных данных. [c.20]

[c.20]

Обработка результатов наблюдений. Данный этап работы по разработке норм затрат труда выполняется математическими методами и заключается а) в очистке хронометражных рядов [c.82]

В практике расчета ущерба приходится сталкиваться с большим числом условностей, значительно обедняющих реальное содержание итогового результата. Основным методом определения ущерба является метод прямого счета, предполагающий непосредственное обследование реципиентов. Другие методы в той или иной степени базируются на нем. Методом прямого счета фактически производится фиксация конкретного состояния, т. е. определение размера ущерба, который потерпело народное хозяйство за определенный промежуток времени на данной конкретной территории. Но этого недостаточно для экономического обоснования решения о проведении природоохранного мероприятия. Необходим расчет предотвращенного ущерба, а следовательно, нужно оценить ущерб в гипотетической ситуации, т. е. в ситуации, которая сложилась бы, если бы природоохранное мероприятие было проведено.

Статистика имеет свои методы получения и обработки данных учета, а именно массовое наблюдение, группировка, обработка, средние числа, индексы, анализ и др. [c.11]

Рассмотрим это на примере. Для правильного использования рабочей силы предприятию надо знать количество рабочих по профилям. Для этого в оперативном учете ежедневно отмечается количество рабочих, явившихся на работу. Статистика пользуется этими данными учета — это метод массового наблюдения. Статистика ведет подсчет рабочих по профессиям — это метод группировки. Периодически, допустим ежемесячно, данные наблюдения и группировки статистика располагает по месяцам в ряды и на каждое первое число месяца производит сравнение количества рабочих в данном месяце с количеством рабочих на начало года — это метод обработки. Полученные сведения о количестве рабочих по профессиям записываются в специальную форму

[c.12]

Периодически, допустим ежемесячно, данные наблюдения и группировки статистика располагает по месяцам в ряды и на каждое первое число месяца производит сравнение количества рабочих в данном месяце с количеством рабочих на начало года — это метод обработки. Полученные сведения о количестве рабочих по профессиям записываются в специальную форму

[c.12]

Фотография рабочего дня, особенно если она не индивидуальная, трудоемка. Поэтому в последнее время широкое распространение получил метод моментных наблюдений. При этом методе наблюдатель обходит рабочие места по заранее составленному маршруту, включающему фиксируемые точки. Состояние и содержание трудового процесса фиксируются в определенный момент. Число замеров (моментов) определяется по формулам математической статистики и достаточно велико. Метод основан на положениях теории вероятности, согласно которой вероятность повторения того или иного элемента во времени в период наблюдения прямо пропорциональна его продолжительности и обратно пропорциональна длительности наблюдения. Наблюдатель фиксирует момент затрат времени на подготовительно-заключительную, основную и вспомогательную работу, обслуживание рабочего места, перерывы в работе и их причины. Обработка данных позволяет выявить нерационально затраченное время.

[c.78]

Наблюдатель фиксирует момент затрат времени на подготовительно-заключительную, основную и вспомогательную работу, обслуживание рабочего места, перерывы в работе и их причины. Обработка данных позволяет выявить нерационально затраченное время.

[c.78]

Проблема оценок особо важна в тех случаях, когда совокупность возникает только в процессе исследования. Так, весь смысл выборочных обследований состоит в том, чтобы получить на основании данных выборки оценки неизвестных величин, характеризующих генеральную совокупность. Все связанные с этим вопросы, относящиеся как к способу обработки данных выборочного наблюдения, так и к его организации, способу отбора выборочной совокупности и др., составляют объект теории выборочного метода. Если же оцениваемая величина относится не к совокупности, а к многократно измеряемому объекту, то входящие сюда вопросы рассматриваются в теории ошибок (измерения), к-рую можно считать исторически родоначальницей М. с. [c.400]

Однако, если вы собираетесь проводить какой-то анализ, вам потребуется более сложный способ получения и обработки данных — с использованием компьютера. Существует три основных метода наблюдения и анализа цен с помощью компьютера (1) использование своего компьютера для доступа к другому компьютеру, на котором проводится анализ (2) использование терминала (предоставляется продавцом данных), способного решать определенные задачи и связываться с главным компьютером продавца данных (3) использование вашего компьютера для загрузки данных и их анализа с помощью собственного программного обеспечения.

[c.375]

Существует три основных метода наблюдения и анализа цен с помощью компьютера (1) использование своего компьютера для доступа к другому компьютеру, на котором проводится анализ (2) использование терминала (предоставляется продавцом данных), способного решать определенные задачи и связываться с главным компьютером продавца данных (3) использование вашего компьютера для загрузки данных и их анализа с помощью собственного программного обеспечения.

[c.375]

На самой деле широкому использованию этого метода препятствует его дороговизна. Дело в том, что организация наблюдений за продажами, сбор и обработка данных требуют немалых затрат, а достижение договоренности с владельцами магазинов о проведении исследований — больших усилий исследователей и некоторого везения. Отметим этой связи, что для получения надежных результатов необходимо обследовать несколько магазинов, а само исследование затягивается на несколько месяцев. Только при таком подходе можно надеяться элиминировать влияние внешних факторов, способных сказаться на динамике продаж в одном отдельно взятом магазине, и определить закономерности, присущие всей генеральной совокупности покупателей. [c.267]

[c.267]

Бухгалтерский учет, как и любая другая наука, имеет собственный предмет, объекты наблюдения и характерные для него специфические приемы и методы регистрации, сбора, обработки, накопления и передачи данных пользователям. [c.69]

Основным и наиболее ответственным этапом разработки нормативов является обработка исходных данных, полученных путем наблюдений, и установление степени влияния на них различных факторов. При небольшом количестве факторов, влияющих на величину затрат времени (до 2—3), целесообразно использовать графоаналитический метод. При большом количестве факторов — регрессионный и дисперсионный анализ. [c.207]

Метод самофотографии рабочего времени — разновидность метода упрощенных наблюдений. Чтобы установить, сколько времени в среднем затрачивается на обработку определенного типа (вида) документов или на выполнение определенного вида работ, необходимо получить данные за достаточно продолжительный период времени. Наиболее простой способ получить такие данные — предложить служащему заполнить лист наблюдения (табл. 2.2).

[c.44]

2.2).

[c.44]

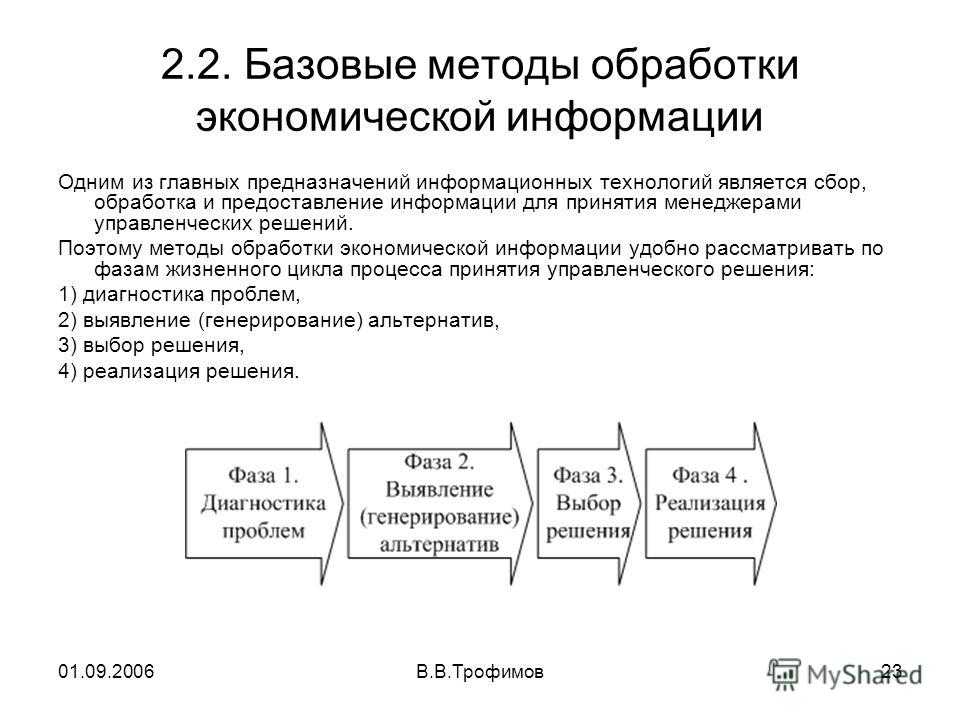

Разработка плана маркетингового исследования — сложный творческий процесс, своего рода фундамент будущего исследования. План позволяет установить рамки и основные направления всего исследования. Прежде всего нужно выбрать необходимые методы его проведения. При этом надо иметь в виду, что это не механический набор методов и приемов, а целенаправленный их выбор для решения конкретных специфических задач. Нужно определить методы и процедуры сбора первичных данных (опрос, наблюдение и т.д.), методы и средства обработки полученных данных (экономико-статистические и экономико-математические методы и т.п.), а также методы анализа и обобщения материалов (моделирование, исследование операций, деловые игры, экспертиза и др.). Затем нужно определить тип требуемой информации и источников ее получения исходя из параметров имеющихся ресурсов (информации, времени и финансовых средств), а также необходимой степени достоверности, надежности данных. Например, надежность информации — результатов анкетирования — определяется обычно размерами выборки (количеством обследуемых субъектов) и репрезентативностью группы целевому сегменту рынка. [c.22]

[c.22]

Любая единица наблюдения обладает множеством признаков. При разработке программы наблюдения следует выбрать существенные для решения задач признаки, ради которых проводится наблюдение. Для этой цели нужно знать сущность и свойства объекта наблюдения и потребности органов управления в данных о нем и исходя из них определить, какие аналитические и сводные показатели необходимы, а в соответствии с последними — какие признаки необходимо подвергнуть наблюдению и включить в программу. Следовательно, для определения программы наблюдения следует в обратном порядке мысленно совершить все этапы статистической работы определить цели и методы анализа, выявить необходимые для анализа сводки и группировки, указать потребные для них признаки объекта, подлежащего наблюдению, наконец, сформулировать вопросы о них в форме отчетности (переписном листе, анкете). Такая последовательность работ по формированию программы является условием включения в нее только всех вопросов, без ответа на которые цели статистической работы не могут быть достигнуты, и невключения в нее тех вопросов, в которых нет необходимости для решения поставленной познавательной или управленческой задачи. Если не включить в программу вопросы, без ответа на которые цель статистической работы не будет достигнута, то статистическое наблюдение окажется ненужным, а средства на его проведение будут истрачены впустую. Если же включить в программу вопросы без четкого представления о том, для чего понадобятся полученные данные, то средства на их сбор и обработку также будут затрачены неэффективно.

[c.21]

Если не включить в программу вопросы, без ответа на которые цель статистической работы не будет достигнута, то статистическое наблюдение окажется ненужным, а средства на его проведение будут истрачены впустую. Если же включить в программу вопросы без четкого представления о том, для чего понадобятся полученные данные, то средства на их сбор и обработку также будут затрачены неэффективно.

[c.21]

Нормативные наблюдения различаются не только способом их проведения, системой записи данных, но и степенью точности учета времени. В табл. 16.2 приводится систематизация нормативных наблюдений в зависимости от назначения разрабатываемых норм. Полученные данные наблюдений тщательно анализируют и очищают от случайных значений. Для обработки этих данных и определения нормативных величин широко применяют методы математи- [c.336]

МАШИННАЯ ИМИТАЦИЯ, или компьютерная имитация [simulation] — экспериментальный метод изучения экономики с помощью компьютеров. (В литературе часто в том же смысле применяется термин «имитационное моделирование», однако, по-видимому, лучше разделить значения моделирование есть разработка, конструирование модели некоторого объекта для его исследования, а имитация — один из возможных способов использования модели. ) Для имитации формируется имитационная система, включающая имитационную модель, а также программное обеспечение ЭВМ. В машину вводятся необходимые данные и ведется наблюдение за тем, как изменяются интересующие исследователя показатели они подвергаются анализу, в частности статистической обработке данных.

[c.190]

) Для имитации формируется имитационная система, включающая имитационную модель, а также программное обеспечение ЭВМ. В машину вводятся необходимые данные и ведется наблюдение за тем, как изменяются интересующие исследователя показатели они подвергаются анализу, в частности статистической обработке данных.

[c.190]

На 3-м этапе разработки проекта нормативов проводят систематизацию данных о необходимых затратах рабочего времени, полученных на различных предприятиях (цехах, рабочих местах) составление сводных балансов затрат рабочего времени по данным фотографий рабочего времени анализ выявленных вариантов выполнения работы и сопоставление их с предварительно спроектированным трудовым процессом уточнение содержания трудового процесса, методов выполнения и факторов продолжительности его обработку результатов наблюдений и вывод математических зависимостей времени выполнения работы от выявленных факторов уточнение макетов таблиц и заполнение их нормативными значениями, рассчитанными по установленным математи-

[c. 38]

38]

Большое развитие как наука и как практич. деятельность С. п. получила при Сов. власти. До Окт. революции 1917 в России сбором и обработкой статистич. данных о пром-сти занимались 3 учреждения по различным программам. В. И. Ленин писал о текущей С. п. в России …у нас имеется лишь лживая, неряшливая канцелярски-путаная статистика разных ведомств»… (Поли. собр. соч., 5 изд., т. 12, с. 354). В этих условиях большое значение имели переписи промышленности, проведённые в России в 1900 и 1908. Теоретич. основы С. п. даны в трудах В. И. Ленина им сформулированы понятия единицы наблюдения и учётной единицы в пром-сти, пром. ценза. Он дал осн. указания о методе группировок в пром-сти, о науч. применении средних в С. и., методах экономико-статистич. анализа и необходимости создания центр, органа статистик . В СССР единым руководящим органом является Управление С. п. ЦСУ СССР, разрабатывающее формы статистич. отчётности для пром. предприятий и объединении, методологию определения показателей, а также занимающееся сбором и обработкой данных с помощью ЭВМ н экономико-статистич. анализа полученных результатов. В СССР данные С. п. публикуются ежегодно в статистич. сб. Народное хозяйсгво СССР , в спец. сб. Промышленность СССР и др. Вопросам С. п. уделяется большое внимание в статистич. комиссиях ООН и СЭВ.

[c.48]

анализа полученных результатов. В СССР данные С. п. публикуются ежегодно в статистич. сб. Народное хозяйсгво СССР , в спец. сб. Промышленность СССР и др. Вопросам С. п. уделяется большое внимание в статистич. комиссиях ООН и СЭВ.

[c.48]

Говоря о методах, приемах познания и его этапах, следует иметь в виду, что исходным пунктом познания является изучение конкретной действительности, практики работы промышленных предприятий, накопление материалов, фактов, характеризующих их производственно-хозяйственную деятельность, как на основе обработки статистических данных, так и путем проведения специальных обследований, наблюдений. При этом нельзя вырывать из всей массы отдельные факты, а нужно брать их во взаимосвязи, в совокупности. Только на этом фундаменте можно выявить типичные явления, обнаружить имевшую место или возникающую закономерность. На это большое внимание обращал В. И. Ленин Чтобы это был действительно фундамент, необходимо брать не отдельные факты, а всю совокупность относящихся к рассматриваемому вопросу фактов, без единого исключения . Вместе с тем, практика не только отправной пункт исследования (познания), но и этап апробации, проверки выдвигаемых положений, методов, так как именно она — практика — критерий истины. Апро-Гация предложений должна проводиться и путем постановки специальных экспериментов, в том числе экономических. Практика, наконец,— это внедрение разработанных методов, реализация предложений.

[c.8]

Вместе с тем, практика не только отправной пункт исследования (познания), но и этап апробации, проверки выдвигаемых положений, методов, так как именно она — практика — критерий истины. Апро-Гация предложений должна проводиться и путем постановки специальных экспериментов, в том числе экономических. Практика, наконец,— это внедрение разработанных методов, реализация предложений.

[c.8]

К сожалению, успех в применении технического анализа полностью зависит от качества метода оптимизации, о которой говорилось выше. Взяв длину промежутка для скользящего среднего равной, например, 125 дням, мы тем самым неизбежно ограничиваем свой выбор среди различных характеристик временных рядов для данной базы данных. Следует понимать, что такие действия, не сопровождающиеся достаточно хорошим подтверждением, могут привести к переобучению и потере способности к обобщению. Более того, многие инвесторы считают, что ключом к успеху в инвестиционном деле является интуиция аналитика, а не применение какой-либо процедуры отбора или формулы. В связи с этим Холи и др. [136] утверждают, что хотя успехи нейронных сетей в распознавании образов и делают возможным их использование в техническом анализе, все же наиболее выигрышные приемы будут, скорее всего, разработаны самими чартистами. Высказываются также предостережения против чрезмерной предварительной обработки входных данных, и поэтому мы воздержались от сверхоптимизации данных. Для того чтобы сохранить статистическую представительность данных, мы выбрали для обучения сети недельный промежуток времени. Для 5-20-1 сети это дает примерно 10 наблюдений на один весовой коэффициент.

[c.213]

В связи с этим Холи и др. [136] утверждают, что хотя успехи нейронных сетей в распознавании образов и делают возможным их использование в техническом анализе, все же наиболее выигрышные приемы будут, скорее всего, разработаны самими чартистами. Высказываются также предостережения против чрезмерной предварительной обработки входных данных, и поэтому мы воздержались от сверхоптимизации данных. Для того чтобы сохранить статистическую представительность данных, мы выбрали для обучения сети недельный промежуток времени. Для 5-20-1 сети это дает примерно 10 наблюдений на один весовой коэффициент.

[c.213]

МАТЕМАТИЧЕСКАЯ СТАТИСТИКА (mathemati al statisti s) — раздел математики, посвященный систематизации, обработке и использованию стат данных В М с мн методы стат обработки исходных данных основываются на вероятностной природе этих данных Оси понятиями М с являются генеральная совокупность (мн-во значений случайной величины), выборка (ограниченное число наблюдений случайной величины), объем выборки (кол-во значений случайной величины в выборке), параметр положения (ср значение случайной величины), мера рассеяния (квадратный корень из дисперсии счучайной величины) и т д Одной из задач М с является построение оценок случайной величины Различают оценки точечные, интервальные, робастные (устойчивые, т е слабо реагирующие на утрату части исходных данных, засорение выборки и т п ), эффективные (имеющие ми-ним дисперсию) и др Получили развитие и нашли широкое практическое применение такие разделы М с, как дисперсионный анализ, кластерный анализ, факторный анализ, методы планирования эксперимента, приемочного контроля статистического и др

[c. 131]

131]

Хронометражные данные являются выборкой из всей статистической совокупности значений длительности той или иной операции или ее элемента. Исходя из этого, необходимое число замеров можно определить методами математической статистики. Однако эти методы не дают возможности заранее, до специальной обработки полученного хронометражного ряда, определить, достаточно ли проведено наблюдений. Поэтому на этапе подготовки к хронометраж-ным наблюдениям пользуются эмпирическими формулами расчета необходимого числа наблюдений и специальными таблицами. Одна лз таких формул, рекомендованная НИИтруда, имеет следующий вид [c.122]

Количественная обработка результатов исследования по психологии » Заказ курсовых, контрольных, дипломных работ

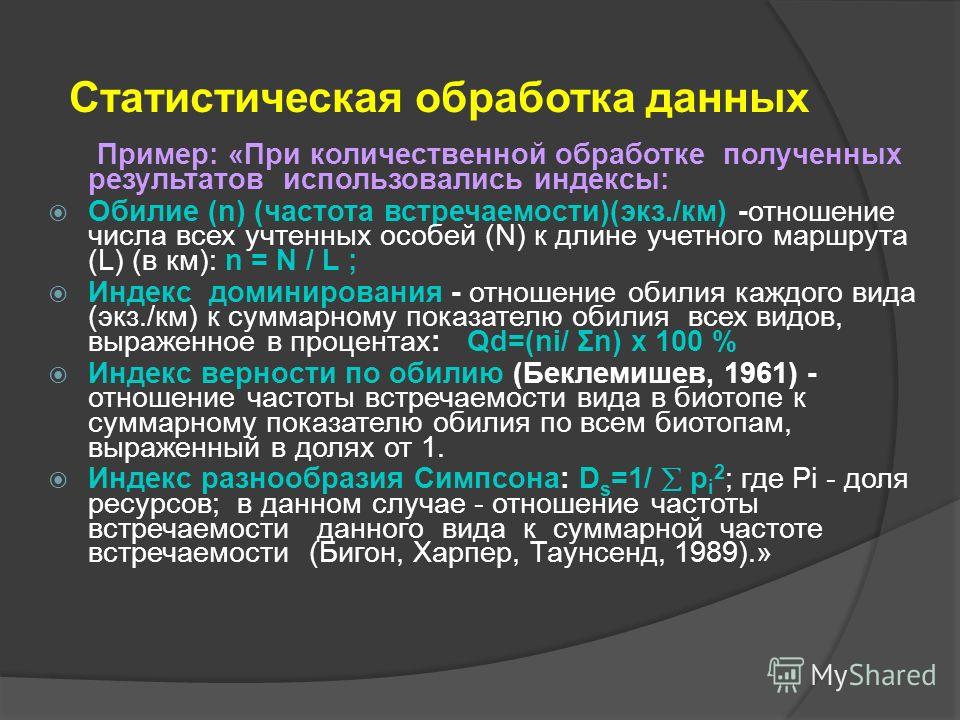

Использование методов математической статистики при обработке первичных эмпирических данных необходимо для повышения достоверности выводов как в научном исследовании, так и в разработке в области практической психологии. При этом не рекомендуется ограничиваться использованием таких показателей, как среднее арифметическое и проценты. Они чаще всего не дают достаточных оснований для обоснованных выводов из эмпирических данных.

Использование методов математической статистики при обработке первичных эмпирических данных необходимо для повышения достоверности выводов как в научном исследовании, так и в разработке в области практической психологии. При этом не рекомендуется ограничиваться использованием таких показателей, как среднее арифметическое и проценты. Они чаще всего не дают достаточных оснований для обоснованных выводов из эмпирических данных.

Они чаще всего не дают достаточных оснований для обоснованных выводов из эмпирических данных.

Использование методов математической статистики при обработке первичных эмпирических данных необходимо для повышения достоверности выводов как в научном исследовании, так и в разработке в области практической психологии. При этом не рекомендуется ограничиваться использованием таких показателей, как среднее арифметическое и проценты. Они чаще всего не дают достаточных оснований для обоснованных выводов из эмпирических данных. Чтобы выбрать статистические критерии и познакомиться с основами их применения для обработки эмпирических данных, можно использовать ряд пособий (например: Большее, Смирнов, 1969; Гласс, Стенли, 1976; Закс, 1976; Сосновский, 1979; Рунион, 1982; Сидоренко, 2001; Калинин, 2002; Ермолаев, 2003; Наследов, 2004). Множество критериев, приводимых обычно в учебниках по математической статистике, и сложное описание процедур их вычисления часто смущают студента, хотя значительная их часть используется достаточно редко. Каждый исследователь (и научный руководитель в том числе) выбирает статистические критерии, исходя из своих знаний, опыта, типа задачи и вида данных, которые подлежат обработке.

Каждый исследователь (и научный руководитель в том числе) выбирает статистические критерии, исходя из своих знаний, опыта, типа задачи и вида данных, которые подлежат обработке.

Как же поступить студенту? Можно положиться на опыт и советы научного руководителя (однако основательно разобравшись при этом в смысле и процедуре критерия). Можно опереться на примеры, приведенные в методических пособиях. Книги Е.В. Сидоренко (2001) и О.Ю. Ермолаева (2003) приводят примеры так называемой «ручной» обработки данных, в книгах С.И. Калинина (2002) и А.Д. Наследова (2004) даны описания статистической обработки с использованием статистических программ.

Статистические гипотезы. Выбор статистических критериев предполагает также формулировку статистических гипотез, то есть перевода экспериментальной гипотезы на язык статистики. Таким образом, статистическая гипотеза — это утверждение в отношении изучаемой переменной, сформулированное на языке математической статистики. Для этого необходимо определить математико-статистические критерии, уровни статистической значимости, которые дают основания исследователю утверждать, подтвердилась экспериментальная гипотеза или нет. На этом этапе исследования формулируются статистические гипотезы, которые конкретизируют соответствующую эмпирическую гипотезу на уровне математических критериев значимости. Эмпирическая (экспериментальная) гипотеза воплощается в процедуре статистической интерпретации данных. Эта процедура сводима к оценке сходств и различий. При проверке статистических гипотез используются два понятия:

На этом этапе исследования формулируются статистические гипотезы, которые конкретизируют соответствующую эмпирическую гипотезу на уровне математических критериев значимости. Эмпирическая (экспериментальная) гипотеза воплощается в процедуре статистической интерпретации данных. Эта процедура сводима к оценке сходств и различий. При проверке статистических гипотез используются два понятия:

Н(1) (гипотеза о различии) и

Н(0) (гипотеза о сходстве).

Подтверждение первой гипотезы свидетельствует о верности статистического утверждения Н(1), а второй — о принятии утверждения Н(0) — об отсутствии различий.

После проведения конкретного эксперимента проверяются многочисленные статистические гипотезы, поскольку в каждом психологическом исследовании регистрируется не один, а множество поведенческих параметров. Каждый параметр характеризуется несколькими статистическими мерами: центральной тенденции, изменчивости, распределения. Кроме того, можно вычислить меры связи параметров и оценить значимость этих связей.

Таким образом, экспериментальная гипотеза служит для организации и проведения эмпирического исследования, а статистическая — для организации процедуры сравнения регистрируемых параметров. Статистическая гипотеза необходима на этапе математической интерпретации данных эмпирических исследований. Естественно, большое количество статистических гипотез необходимо для подтверждения или опровержения экспериментальной (эмпирической) гипотезы.

Выбирать математические методы обработки эмпирических данных нужно в процессе планирования исследования. Выбор метода математической обработки полученных эмпирических данных — очень важная и ответственная часть исследования. И делать это лучше до того, как получены данные. При планировании исследования необходимо заранее продумать, какие эмпирические показатели будут регистрироваться, с помощью каких методов будут обрабатываться и какие выводы при разных результатах обработки можно будет сделать. Полезным руководством при этом может стать классификация задач и методов их решения, которую приводит Е. В. Сидоренко (2001, с. 34).

В. Сидоренко (2001, с. 34).

Следует идентифицировать тип переменных и шкалу измерения. При выборе математико-статистического критерия нужно, прежде всего, идентифицировать тип переменных (признаков) и шкалу, которая использовалась при измерении психологических показателей и других переменных (возраст, состав семьи, уровень образования).

В качестве переменных могут выступать любые показатели, которые можно сравнивать друг с другом (то есть измерять). Это может быть время выполнения задания, количество ошибок, уровень самооценки, количество правильно решенных задач и качественные особенности их выполнения, личностные показатели, получаемые в психологических тестах, и др. Порой для студентов представляет трудность выделение переменных в работах по практической психологии, где возможности использования традиционных и стандартизированных психологических тестов (с которыми обычно ассоциируется проблема измерения) ограничены. Следует иметь в виду, что в области практической психологии могут широко использоваться номинативные и порядковые шкалы. Речевые высказывания клиента, виды поведенческих реакций, улыбки, взгляды, — все это может рассматриваться в качестве переменных. Главное — иметь четкие и ясные критерии их отнесения к тому или иному типу в зависимости от поставленных гипотез и задач.

Речевые высказывания клиента, виды поведенческих реакций, улыбки, взгляды, — все это может рассматриваться в качестве переменных. Главное — иметь четкие и ясные критерии их отнесения к тому или иному типу в зависимости от поставленных гипотез и задач.

Нужно учитывать тип распределения данных при выборе статистического критерия. При выборе математико-статистического критерия следует также ориентироваться на тип распределения данных, который получился в исследовании. Параметрические критерии используются в том случае, когда распределение полученных данных рассматривается как нормальное. Нормальное распределение с большей вероятностью (но не обязательно) получается при выборках более 100 испытуемых (может получиться и при меньшем количестве, а может не получиться и при большем). При использовании параметрических критериев необходима проверка нормальности распределения.

Для непараметрических критериев тип распределения данных не имеет значения. При небольших объемах выборки испытуемых, используемой обычно в курсовой или дипломной работе, целесообразно выбрать непараметрические критерии, которые дают большую достоверность выводам, независимо от того, получено ли в исследовании нормальное распределение данных. В некоторых случаях статистически обоснованные выводы могут быть сделаны даже при выборках в 5-10 испытуемых.

В некоторых случаях статистически обоснованные выводы могут быть сделаны даже при выборках в 5-10 испытуемых.

Основные типы исследовательских задач с точки зрения статистических процедур обработки данных. Большинство психологических работ сводятся к нескольким типам исследовательских задач, которые и предопределяют тип математико-статистического критерия.

1. Во многих исследованиях осуществляется поиск различий в психологических показателях у испытуемых, имеющих те или иные особенности. При обработке соответствующих данных могут использоваться критерии для выявления различий в уровне исследуемого признака или в его распределении. Для определения значимости различий в проявлении признака в психологических исследованиях часто используются такие показатели, как парный критерий Вилкоксона, U-критерий Манна-Уитни, критерий хи-квадрат (x2), точный критерий Фишера, биномиальный критерий.

2. Во многих исследованиях осуществляется поиск взаимосвязи психологических показателей у одних и тех же испытуемых. Для обработки соответствующих данных могут использоваться коэффициенты корреляции. Связь величин друг с другом и их зависимость часто характеризуются коэффициентом линейной корреляции Пирсона и коэффициентом ранговой корреляции Спирмена.

Для обработки соответствующих данных могут использоваться коэффициенты корреляции. Связь величин друг с другом и их зависимость часто характеризуются коэффициентом линейной корреляции Пирсона и коэффициентом ранговой корреляции Спирмена.

3. Выявление структуры данных (и соответственно структуры изучаемой психологической реальности), а также их взаимосвязи выявляется факторным анализом.

4. Во многих исследованиях интерес представляет анализ изменчивости признака под влиянием каких-либо контролируемых факторов, или, другими словами, оценка влияния разных факторов на изучаемый признак. Для математической обработки данных в таких задачах может использоваться U-критерий Манна-Уитни, критерий Краскела-Уоллиса, Т-критерий Вилкоксона, критерий x2 Фридмана. Однако для исследования влияния нескольких факторов на изучаемый параметр (а тем более их взаимовлияния) полезнее может оказаться дисперсионный анализ. Исследователь исходит из предположения, что одни переменные могут рассматриваться как причины, а другие как следствия. Переменные первого рода считаются факторами, а переменные второго рода — результативными признаками. В этом отличие дисперсионного анализа от корреляционного, в котором предполагается, что изменения одного признака просто связаны с определенными изменениями другого (Сидоренко, 2001, с. 225).

Переменные первого рода считаются факторами, а переменные второго рода — результативными признаками. В этом отличие дисперсионного анализа от корреляционного, в котором предполагается, что изменения одного признака просто связаны с определенными изменениями другого (Сидоренко, 2001, с. 225).

5. Во многих исследованиях выявляется значимость изменений (сдвига) каких-либо психологических, поведенческих параметров и проявлений за определенный промежуток времени в определенных условиях (например, в условиях коррекционного воздействия). Формирующие эксперименты в практической психологии решают именно эту задачу. Для обработки соответствующих данных могут использоваться коэффициенты оценки достоверности сдвига в значениях исследуемого признака. Для этого часто применяются критерии знаков, Т-критерий Вилкоксона.

Важно обратить внимание на ограничения, которые имеет каждый критерий. Если один критерий не подходит для анализа имеющихся данных, всегда можно найти какой-либо другой, возможно, изменив тип представления самих данных. Прежде чем обрабатывать эмпирические данные, полезно проверить, существуют ли в пособии, которым вы пользуетесь, критические значения, соответствующие количеству и типу ваших данных. В противном случае вас может ждать разочарование, когда ваши подсчеты окажутся напрасными по причине отсутствия в таблице критических значений при объеме выборки, которая у вас была.

Прежде чем обрабатывать эмпирические данные, полезно проверить, существуют ли в пособии, которым вы пользуетесь, критические значения, соответствующие количеству и типу ваших данных. В противном случае вас может ждать разочарование, когда ваши подсчеты окажутся напрасными по причине отсутствия в таблице критических значений при объеме выборки, которая у вас была.

После знакомства с процедурой вычисления критерия можно провести «ручную» обработку данных или воспользоваться статистической программой персонального компьютера. Для компьютерной обработки одни психологи предпочитают пакет статистических программ SPSS, другие — программу Statistica. Студенты-психологи предпочитают SPSS, прежде всего, потому, что в последние годы опубликованы хорошие руководства по его применению (Калинин, 2002; Наследов, 2004).

Методы математической обработки данных важно использовать и для анализа результатов инновационной практической психологической работы: психотерапии, консультирования, развивающей психологической работы. Для этого необходимо регистрировать конкретные психологические и поведенческие показатели участников исследования «до» и «после» курса психологической помощи, которые могут статистически обрабатываться и использоваться для подтверждения эффективности курса занятий. Применение математико-статистических критериев для проверки значимости изменений придает доказательность выводам такой работы.шаблоны для dle 11.2

Для этого необходимо регистрировать конкретные психологические и поведенческие показатели участников исследования «до» и «после» курса психологической помощи, которые могут статистически обрабатываться и использоваться для подтверждения эффективности курса занятий. Применение математико-статистических критериев для проверки значимости изменений придает доказательность выводам такой работы.шаблоны для dle 11.2

Научный вебинар «Методы обработки полуструктурированных текстов для задач классификации и генерации контента»

Вебинар состоялся 24 сентября 2020 г. В этот раз мы обсуждали методы обработки полуструктурированных текстов для задач классификации и генерации контента.

Во время данного вебинара были рассмотрены следующие вопросы:

Методы обработки полуструктурированных текстов для задач классификации и генерации контента

Генерация какого-либо текстового контента требует решения не только самой задачи генерации, но и первичного анализа имеющейся информации, которая зачастую сама представлена в текстовом виде. Последнее приводит к необходимости разработки sequence-to-sequence методов и подходов обработки данных. Ситуацию может усложнять большой объем входных данных, из которого нужно выделить действительно существенные части, обработав которые можно будет произвести необходимый контент. В свою очередь, это влечет необходимость разработки целых каскадов из вспомогательных и основных методов для получения хорошего результата. В докладе будут рассмотрены современные нейросетевые методы генерации текстового контента на примерах задач генерации рекламы и вопросно-ответных систем.

Последнее приводит к необходимости разработки sequence-to-sequence методов и подходов обработки данных. Ситуацию может усложнять большой объем входных данных, из которого нужно выделить действительно существенные части, обработав которые можно будет произвести необходимый контент. В свою очередь, это влечет необходимость разработки целых каскадов из вспомогательных и основных методов для получения хорошего результата. В докладе будут рассмотрены современные нейросетевые методы генерации текстового контента на примерах задач генерации рекламы и вопросно-ответных систем.

Докладчик:

Николай Бутаков, руководитель научной группы анализа социальных медиа в НЦКР Университета ИТМО

Оптимизация тематических моделей в рамках эксплоративного анализа и представления текстовых данных.

Тематическое моделирование — популярный метод для обработки текстов с целью эксплоративного анализа, позволяющий получить интерпретируемое представление документа без дополнительных затрат на разметку текста. Полученные распределения по темам могут использоваться как базис для обучения конечным задачам, например классификации. Однако, при работе с разнообразными наборами данных для получения желаемого качества требуется использование сложных моделей с большим числом регуляризаторов. Обилие настраиваемых параметров, а также необходимость их применения в определенном порядке приводит к возникновению задачи оптимизации стратегии построения тематических моделей.

Полученные распределения по темам могут использоваться как базис для обучения конечным задачам, например классификации. Однако, при работе с разнообразными наборами данных для получения желаемого качества требуется использование сложных моделей с большим числом регуляризаторов. Обилие настраиваемых параметров, а также необходимость их применения в определенном порядке приводит к возникновению задачи оптимизации стратегии построения тематических моделей.

Докладчик:

Мария Ходорченко, научный сотрудник группы инфраструктуры больших данных и анализа публичных источников в НЦКР Университета ИТМО

Методы работы с короткими (и не только) текстовыми данными без разметки с помощью нейронных сетей для автоклассификации текста.

Рост числа данных приводит к увеличения числа подзадач в работе с текстовыми данными, например, возникают новые доменные области. Обычно под эти задачи нет дополнительной разметки и необходимы методы, не требующие её. Применение тематических моделей в таких ситуациях не всегда подходит — тексты могут быть короткими, кроме того, классические тематические модели не учитывают связи между словами и не позволяют определять какие части текста соответствует выделенным тематикам. Последние разработки в области нейронных сетей для текстовых данных позволяют исправить эти недостатки.

Обычно под эти задачи нет дополнительной разметки и необходимы методы, не требующие её. Применение тематических моделей в таких ситуациях не всегда подходит — тексты могут быть короткими, кроме того, классические тематические модели не учитывают связи между словами и не позволяют определять какие части текста соответствует выделенным тематикам. Последние разработки в области нейронных сетей для текстовых данных позволяют исправить эти недостатки.

Докладчик:

Тимур Сохин, научный сотрудник группы инфраструктуры больших данных и анализа публичных источников в НЦКР Университета ИТМО

СПИСОК ЛИТЕРАТУРЫ1. Современные методы измерения, обработки и интерпретации электромагнитных данных. |

Capitols | Капитолс — Большие данные: инструменты и методы обработки

В конкурентном мире, вынуждающем соперничающие компании постоянно снижать маржинальность, бизнес рассматривает большие данные как возможность получить абсолютное оружие в борьбе за выживание. Что же такое большие данные и почему о них надо волноваться?

Что же такое большие данные и почему о них надо волноваться?

Термин «большие данные» (Big Data) означает набор инструментов и методов обработки структурированных и неструктурированных данных огромных размеров, находящихся в разных источниках, а также получаемый результат такой обработки. Как правило, размер обрабатываемых данных может начинаться от террабайт и выше (1 TB = 1,000 GB).

По данным исследования IDC Digital Universe, размер накапливаемого объема информации с каждым годом растет экспоненциально. В случае, если вовремя не применить необходимые инструменты по обработке таких данных, это может привести к потере ценной информации и, возможно, краху компании.

Также, согласно исследованиям компании IDC, в большинстве предприятий используется как минимум пять различных систем для автоматизации бизнес процессов. В некоторых предприятиях могут использоваться несколько десятков, а иногда, и несколько сотен различных источников данных.

Как собрать, подготовить, отфильтровать и систематизировать большие массивы данных разного формата и получить необходимую информацию в реальном времени?

Для решения таких задач существуют современные и эффективные программные средства, позволяющие самостоятельно и мгновенно агрегировать и обработать большие массивы различных типов данных из разных источников без привлечения ИТ специалистов.

Компания Capitols предлагает уникальное решение Alteryx. Это высокотехнологичная платформа для поиска, смешивания, фильтрации, совместного исследования, масштабирования и анализа данных методом визуального программирования. Обладает 250+ code-free, code-friendly и drag-and-drop инструментами, которые позволяют самостоятельно и без знаний программирования исследовать большие массивы данных.

Методы воспроизведения и обработки данных — Студопедия

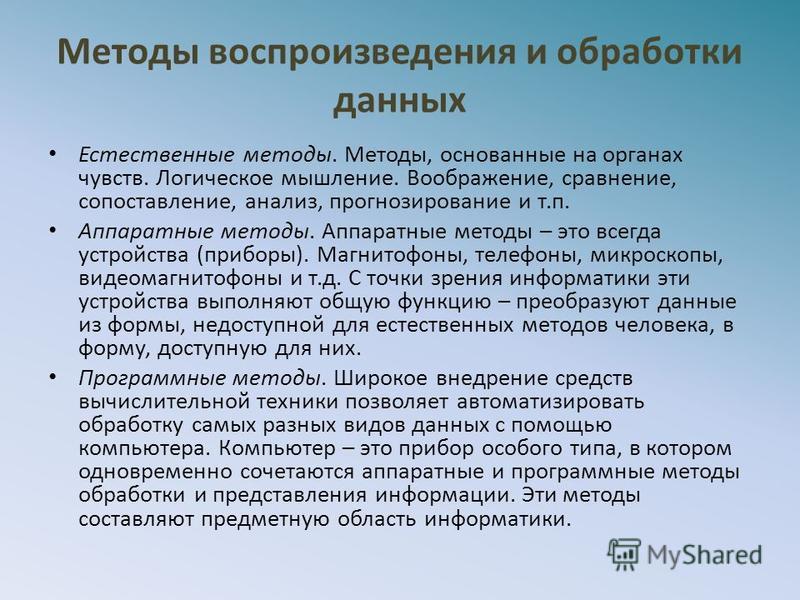

Естественные методы. Методы, основанные на органах чувств. Логическое мышление. Воображение, сравнение, сопоставление, анализ, прогнозирование и т.п.

Аппаратные методы. Аппаратные методы – это всегда устройства (приборы). Магнитофоны, телефоны, микроскопы, видеомагнитофоны и т.д. С точки зрения информатики эти устройства выполняют общую функцию – преобразуют данные из формы, недоступной для естественных методов человека, в форму, доступную для них. Не всегда одни устройства могут обрабатывать данные созданные другими приборами. В таких случаях применяют специальные устройства преобразования данных, и говорят не о преобразовании формы данных, а о преобразовании их формата (модемы, бытовые видеокамеры).

В таких случаях применяют специальные устройства преобразования данных, и говорят не о преобразовании формы данных, а о преобразовании их формата (модемы, бытовые видеокамеры).

Программные методы. Широкое внедрение средств вычислительной техники позволяет автоматизировать обработку самых разных видов данных с помощью компьютера. Компьютер – это прибор особого типа, в котором одновременно сочетаются аппаратные и программные методы обработки и представления информации. Эти методы составляют предметную область информатики.

Если предположить, что информация – это динамический объект, не существующий в природе сам по себе, а образующийся в ходе взаимодействия данных и методов, и существующий столько, сколько длится это взаимодействие, а все остальное время пребывающий в виде данных, то можно дать такое определение:

Информация — это продукт взаимодействия данных и методов, рассмотренный в контексте этого взаимодействия.

Контекстным (адекватным) считается тот метод, который является общепринятым для работы с данными определенного типа. Этот метод должен быть известен как создателю данных, так и потребителю информации.

Этот метод должен быть известен как создателю данных, так и потребителю информации.

Для графических данных (иллюстраций) контекстным является метод наблюдения, основанный на зрении. В этом случае имеется в виду визуальная или графическая информация. Для текстовых данных подразумевается контекстный метод чтения, основанный на зрении, знании азбуки и языка. В этом случае говорят о текстовой информации.

Для данных, представленных в виде радиоволн, контекстными являются аппаратные методы преобразования данных и потребления информации с помощью радиоприемника или телевизора. Поэтому часто используются понятия телевизионная информация, информационная программа, информационный выпуск и т.п.

Для данных, хранящихся в компьютере, передающихся по сетям, контекстными являются аппаратные и программные методы вычислительной техники. Их еще называют средствами информационных технологий, которые входят в предметную область информатики. В этом случае используется понятие компьютерной информации.

Материалы 18-й Всероссийской открытой конференции «Современные проблемы дистанционного зондирования Земли из космоса»

Материалы 18-й Всероссийской открытой конференции «Современные проблемы дистанционного зондирования Земли из космоса»XVIII.A.261

Фурман Ю.В. (1), Скрипачев В.О. (2), Жуков А.О. (1,3,4), Окунев Е.В. (1)

(1) АО «Особое конструкторское бюро Московского энергетического института», Москва, Россия

(2) Российский технологический университет (МИРЭА), Москва, Россия

(3) Экспертно-аналитический центр, Москва, Россия

(4) Институт астрономии Российской академии наук, Москва, Россия

В данном докладе рассмотрены современные методы обработки данных, полученных космическими аппаратами дистанционного зондирования Земли (КА ДЗЗ): автоматической сегментации, спектрального разделения, выделения с применением обучаемой искусственной нейронной сети и др. Изучены актуальные проблемы и тенденции развития рассмотренных методов.

Техническое совершенствование целевой аппаратуры КА ДЗЗ, наращивание орбитальной группировки и расширение спектра решаемых ими прикладных задач приводят к стремительному росту объема поступающих данных, требующих дальнейшей обработки, анализа и интерпретации. Это приводит к повышению требований к быстродействию и качеству методов обработки данных, полученных КА ДЗЗ.

Для решения данных задач в современных методах обработки данных ДЗЗ нашли широкое применение самые актуальные алгоритмы и технологии, такие как параллельное и распределенные вычисление, искусственные нейронные сети, программируемые логические интегральные схемы и др. Благодаря этому повышается быстродействие выполнения прикладных задач, появляется возможность применения более требовательных к производительности методов, повышается качество и точность получаемых результатов.

Работа подготовлена при финансовой поддержке гранта Президента (проект НШ-2686.2020.8 «Модели, методы и средства получения и обработки информации о космических объектах в широком спектральном диапазоне электромагнитных волн»).

Ключевые слова: Дистанционное зондирование Земли, обработка данных, распознавание, искусственная нейронная сеть

Литература:

- Современные технологии обработки данных дистанционного зондирования Земли / Под. ред В.В. Еремеева. М.: ФИЗМАТЛИТ, 2015.

- Абрамов Н. С. и др. Современные методы интеллектуальной обработки данных ДЗЗ // Программные системы: теория и приложения, т. 9, №4(39), с.417-442, 2018.

- Ращупкин А. В. Методы обработки данных дистанционного зондирования для повышения качества выходных изображений // Вестник Самарского университета. Аэрокосмическая техника, технологии и машиностроение, №2(22), с.124-133, 2010.

Ссылка для цитирования: Фурман Ю.В., Скрипачев В.О., Жуков А.О., Окунев Е.В. Современные методы обработки данных дистанционного зондирования Земли // Материалы 18-й Всероссийской открытой конференции «Современные проблемы дистанционного зондирования Земли из космоса». Москва: ИКИ РАН, 2020. C. 53. DOI 10.21046/18DZZconf-2020a

Методы и алгоритмы обработки спутниковых данных

53

Типы, методы, этапы цикла обработки данных

Независимо от того, используете ли вы Интернет для изучения определенной темы, завершения финансовых операций в Интернете, заказа еды и т. Д., Данные генерируются каждую секунду. Использование социальных сетей, онлайн-покупок и сервисов потокового видео увеличило объем данных. По оценкам исследования Domo, в 2020 году для каждого человека на планете каждую секунду создается 1,7 МБ данных. И для того, чтобы использовать и получить представление о таком огромном количестве данных, в игру вступает обработка данных.

Д., Данные генерируются каждую секунду. Использование социальных сетей, онлайн-покупок и сервисов потокового видео увеличило объем данных. По оценкам исследования Domo, в 2020 году для каждого человека на планете каждую секунду создается 1,7 МБ данных. И для того, чтобы использовать и получить представление о таком огромном количестве данных, в игру вступает обработка данных.

Что такое обработка данных?

Данные в необработанном виде бесполезны для какой-либо организации. Обработка данных — это метод сбора необработанных данных и их преобразования в полезную информацию. Обычно это выполняется поэтапно группой специалистов по обработке данных и инженеров по данным в организации. Необработанные данные собираются, фильтруются, сортируются, обрабатываются, анализируются, сохраняются и затем представляются в читаемом формате.

Обработка данных имеет решающее значение для организации более эффективных бизнес-стратегий и повышения их конкурентоспособности.Преобразуя данные в читаемый формат, такой как графики, диаграммы и документы, сотрудники всей организации могут понимать и использовать данные.

Программа последипломного образования в области инженерии данных

Ваш путь к курсу ExpertView по разработке данныхЦикл обработки данных

Цикл обработки данных состоит из серии этапов, на которых необработанные данные (входные данные) передаются в процесс (ЦП) для получения практических сведений (выход). Каждый шаг выполняется в определенном порядке, но весь процесс повторяется циклически.Выходные данные первого цикла обработки данных могут быть сохранены и использованы в качестве входных данных для следующего цикла.

Рис: Цикл обработки данных (источник)

Как правило, цикл обработки данных состоит из шести основных этапов:

Шаг 1: Сбор

Сбор необработанных данных — это первый шаг цикла обработки данных. Тип собранных необработанных данных имеет огромное влияние на получаемые результаты. Следовательно, необработанные данные следует собирать из определенных и точных источников, чтобы последующие результаты были достоверными и пригодными для использования. Необработанные данные могут включать денежные показатели, файлы cookie веб-сайта, отчеты о прибылях и убытках компании, поведение пользователей и т. Д.

Необработанные данные могут включать денежные показатели, файлы cookie веб-сайта, отчеты о прибылях и убытках компании, поведение пользователей и т. Д.

Шаг 2: Подготовка

Подготовка или очистка данных — это процесс сортировки и фильтрации необработанных данных для удаления ненужных и неточных данных. Необработанные данные проверяются на наличие ошибок, дублирования, просчетов или отсутствующих данных и преобразуются в подходящую форму для дальнейшего анализа и обработки. Это сделано для того, чтобы в блок обработки поступали данные только самого высокого качества.

Шаг 3: Введите

На этом этапе необработанные данные преобразуются в машиночитаемую форму и передаются в блок обработки. Это может быть в форме ввода данных через клавиатуру, сканер или любой другой источник ввода.

Шаг 4: Обработка данных

На этом этапе необработанные данные подвергаются различным методам обработки данных с использованием алгоритмов машинного обучения и искусственного интеллекта для получения желаемого результата. Этот шаг может незначительно отличаться от процесса к процессу в зависимости от источника обрабатываемых данных (озера данных, онлайн-базы данных, подключенные устройства и т. Д.) и предполагаемое использование вывода.

Этот шаг может незначительно отличаться от процесса к процессу в зависимости от источника обрабатываемых данных (озера данных, онлайн-базы данных, подключенные устройства и т. Д.) и предполагаемое использование вывода.

Шаг 5: Вывод

Данные, наконец, передаются и отображаются пользователю в удобочитаемой форме, такой как графики, таблицы, векторные файлы, аудио, видео, документы и т. Д. Эти выходные данные могут быть сохранены и далее обработаны в следующем цикле обработки данных.

Шаг 6: Хранение

Последним этапом цикла обработки данных является хранение, где данные и метаданные хранятся для дальнейшего использования. Это обеспечивает быстрый доступ к информации и ее извлечение, когда это необходимо, а также позволяет напрямую использовать ее в качестве входных данных в следующем цикле обработки данных.

Типы обработки данных

Существуют разные типы обработки данных в зависимости от источника данных и шагов, предпринимаемых блоком обработки для генерации вывода. Не существует универсального метода, который можно было бы использовать для обработки необработанных данных.

Не существует универсального метода, который можно было бы использовать для обработки необработанных данных.

Тип | использует |

Пакетная обработка | Данные собираются и обрабатываются партиями. Используется для больших объемов данных. Например: система расчета заработной платы |

Обработка в реальном времени | Данные обрабатываются в течение нескольких секунд после ввода. Используется для небольших объемов данных. Например: снятие денег в банкомате |

Онлайн-обработка | Данные автоматически загружаются в ЦП, как только становятся доступными. Используется для непрерывной обработки данных. Например: сканирование штрих-кода |

Многопроцессорность | Данные разбиваются на кадры и обрабатываются с использованием двух или более процессоров в одной компьютерной системе. Например: прогноз погоды |

Разделение времени | Распределяет ресурсы компьютера и данные во временных интервалах между несколькими пользователями одновременно. |

Руководство по собеседованию с Data Engineer

Вот как пройти собеседование при первом запускеЗагрузить сейчасМетоды обработки данных

Существует три основных метода обработки данных — ручной, механический и электронный.

Ручная обработка данных

В этом методе обработки данных данные обрабатываются вручную. Весь процесс сбора данных, фильтрации, сортировки, вычислений и других логических операций выполняется с участием человека без использования каких-либо других электронных устройств или программного обеспечения для автоматизации. Это недорогой метод, не требующий почти никаких инструментов, но он дает большое количество ошибок, высокие затраты на рабочую силу и много времени.

Обработка механических данных

Данные обрабатываются механически с помощью устройств и машин.Это могут быть простые устройства, такие как калькуляторы, пишущие машинки, печатный станок и т. Д. С помощью этого метода можно выполнить простые операции обработки данных. В нем гораздо меньше ошибок, чем при ручной обработке данных, но увеличение объема данных сделало этот метод более сложным и трудным.

Электронная обработка данных

Данные обрабатываются с использованием современных технологий с использованием программного обеспечения и программ обработки данных. Программному обеспечению предоставляется набор инструкций для обработки данных и вывода результатов.Этот метод является наиболее дорогим, но обеспечивает максимальную скорость обработки при высочайшей надежности и точности вывода.

Примеры обработки данных

Обработка данных происходит в нашей повседневной жизни независимо от того, осознаем мы это или нет. Вот несколько реальных примеров обработки данных:

- Программное обеспечение для торговли акциями, которое преобразует миллионы данных об акциях в простой график

- Компания электронной торговли использует историю поиска клиентов, чтобы рекомендовать аналогичные продукты

- Компания цифрового маркетинга использует демографические данные о людях для разработки стратегии кампаний с учетом местоположения

- Беспилотный автомобиль использует данные от датчиков в реальном времени, чтобы определять, есть ли на дороге пешеходы и другие автомобили

Хотите начать свою карьеру в качестве инженера по большим данным? Пройдите курс обучения инженеров по большим данным и получите сертификат.

Вот что вы можете сделать дальше

Data содержит много полезной информации для организаций, исследователей, учреждений и отдельных пользователей. С увеличением количества данных, генерируемых каждый день, необходимо больше специалистов по обработке данных и инженеров по обработке данных, которые помогли бы понять эти данные. Сертификационный курс по проектированию данных Simplilearn в сотрудничестве с IBM и в партнерстве с Purdue University предлагает высочайший опыт обучения, который поможет вам овладеть важнейшими навыками проектирования данных.Эта программа, основанная на академических достижениях Университета Пердью в области инженерии данных и отраслевом и практическом опыте обучения IBM, поможет ускорить вашу карьеру в качестве специалиста по разработке данных.

Что такое обработка данных? Определение и этапы

Без обработки данных компании ограничивают свой доступ именно к данным, которые могут улучшить их конкурентное преимущество и предоставить критически важные бизнес-идеи. Вот почему всем компаниям важно понимать необходимость обработки всех своих данных и то, как это делать.

Вот почему всем компаниям важно понимать необходимость обработки всех своих данных и то, как это делать.

Что такое обработка данных?

Обработка данных происходит, когда данные собираются и преобразуются в полезную информацию. Обычно обработка данных выполняется специалистом по данным или группой специалистов по данным, поэтому важно, чтобы обработка данных выполнялась правильно, чтобы не повлиять на конечный продукт или вывод данных.

Обработка данных начинается с данных в их необработанном виде и преобразует их в более читаемый формат (графики, документы и т. Д.), Придавая им форму и контекст, необходимые для интерпретации компьютерами и использования сотрудниками всей организации.

Загрузите The Definitive Guide to Data Integration

прямо сейчас.

Прочитай сейчас

Шесть этапов обработки данных

1. Сбор данных

Сбор данных — это первый шаг в обработке данных. Данные берутся из доступных источников, включая озера данных и хранилища данных. Важно, чтобы доступные источники данных были надежными и хорошо построенными, чтобы собранные данные (а затем использованные в качестве информации) имели максимально возможное качество.

Данные берутся из доступных источников, включая озера данных и хранилища данных. Важно, чтобы доступные источники данных были надежными и хорошо построенными, чтобы собранные данные (а затем использованные в качестве информации) имели максимально возможное качество.

2. Подготовка данных

После того, как данные собраны, они перейдут на этап подготовки данных. Подготовка данных, часто называемая «предварительной обработкой», — это этап, на котором необработанные данные очищаются и организуются для следующего этапа обработки данных. Во время подготовки необработанные данные тщательно проверяются на наличие ошибок. Цель этого шага — удалить неверные данные (избыточные, неполные или неверные данные) и начать создавать высококачественные данные для лучшей бизнес-аналитики.

3. Ввод данных

Чистые данные затем вводятся в место назначения (возможно, в CRM, например, в Salesforce, или в хранилище данных, например, Redshift), и переводятся на понятный язык. Ввод данных — это первый этап, на котором необработанные данные начинают принимать форму полезной информации.

Ввод данных — это первый этап, на котором необработанные данные начинают принимать форму полезной информации.

4. Обработка

На этом этапе данные, введенные в компьютер на предыдущем этапе, фактически обрабатываются для интерпретации. Обработка выполняется с использованием алгоритмов машинного обучения, хотя сам процесс может незначительно отличаться в зависимости от источника обрабатываемых данных (озера данных, социальные сети, подключенные устройства и т. Д.)) и его предполагаемое использование (изучение рекламных шаблонов, медицинская диагностика с подключенных устройств, определение потребностей клиентов и т. д.).

5. Вывод / интерпретация данных

Этап вывода / интерпретации — это этап, на котором данные, наконец, становятся доступными для специалистов, не занимающихся данными. Он переведен, удобочитаем и часто в виде графиков, видео, изображений, обычного текста и т. Д.). Теперь сотрудники компании или учреждения могут начать самообслуживание данных для своих собственных проектов анализа данных.

6. Хранение данных

Заключительный этап обработки данных — хранение. После обработки всех данных они сохраняются для будущего использования. Хотя некоторая информация может быть использована сразу же, большая часть ее позже пригодится. Кроме того, правильно сохраненные данные необходимы для соблюдения законодательства о защите данных, такого как GDPR. Когда данные хранятся должным образом, члены организации могут быстро и легко получить к ним доступ при необходимости.

Будущее обработки данных

Будущее обработки данных находится в облаке.Облачные технологии основаны на удобстве современных методов электронной обработки данных и повышают ее скорость и эффективность. Более быстрые и качественные данные означают, что каждая организация может использовать больше данных и извлекать более ценные сведения.

Загрузите Почему ваше следующее хранилище данных должно быть в облаке

прямо сейчас.

Прочитай сейчас

По мере миграции больших данных в облако компании получают огромные преимущества. Облачные технологии больших данных позволяют компаниям объединить все свои платформы в одну легко адаптируемую систему. По мере изменений и обновлений программного обеспечения (как это часто бывает в мире больших данных) облачные технологии легко интегрируют новое со старым.

Облачные технологии больших данных позволяют компаниям объединить все свои платформы в одну легко адаптируемую систему. По мере изменений и обновлений программного обеспечения (как это часто бывает в мире больших данных) облачные технологии легко интегрируют новое со старым.

Преимущества облачной обработки данных никоим образом не ограничиваются крупными корпорациями. Фактически, небольшие компании могут получить большие выгоды сами. Облачные платформы могут быть недорогими и обеспечивать гибкость для роста и расширения возможностей по мере роста компании.Это дает компаниям возможность масштабироваться без высокой цены.

От обработки данных к аналитике

Большие данные меняют то, как все мы ведем бизнес. Сегодня сохранение гибкости и конкурентоспособности зависит от наличия четкой и эффективной стратегии обработки данных. Хотя шесть этапов обработки данных не изменятся, облако привело к огромному прогрессу в технологиях, которые на сегодняшний день предоставляют самые передовые, экономичные и быстрые методы обработки данных.

Станьте мастером обработки данных.

Загрузите бесплатную пробную версию Talend Cloud Integration Platform прямо сейчас.

Скачать бесплатную пробную версию Talend Cloud

5 типов обработки данных

Прежде чем вы сможете использовать какие-либо структурированные и неструктурированные данные, которые вы собираете, эти данные должны быть обработаны.

Самый простой пример обработки данных — визуализация данных. Например, большинство CRM могут выдавать отчеты об анализе данных в виде графиков. Однако, чтобы добраться до этой точки, данные подвергаются ряду операций преобразования.

Существует несколько различных типов обработки данных, которые, помимо прочего, различаются по доступности, атомарности и параллелизму.

Содержание

1. Почему имеет значение метод обработки данных?

2. Обработка транзакций

5. Распределенная обработка

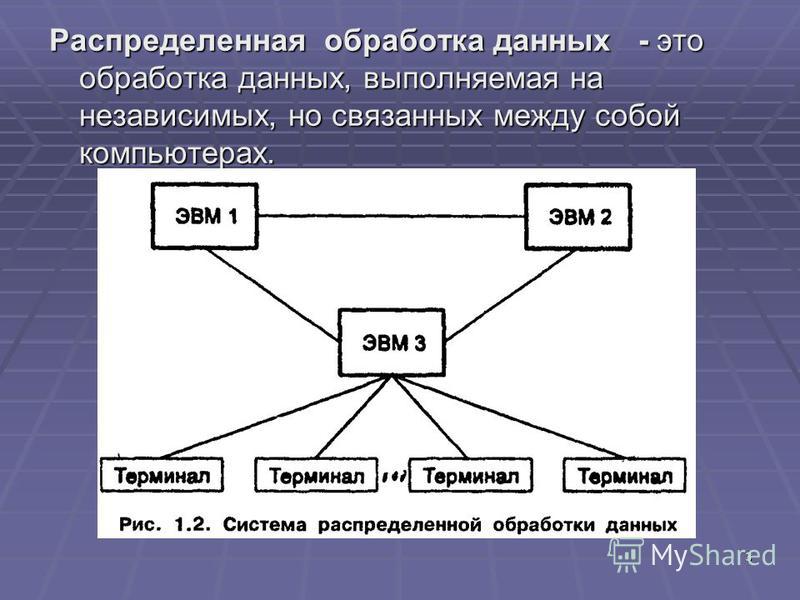

Распределенная обработка

3. Обработка в реальном времени

4. Пакетная обработка

6.Многопроцессорность

7. Подготовка данных к обработке

Почему имеет значение метод обработки данных?

Используемый вами метод обработки данных определяет время ответа на запрос и надежность вывода. Таким образом, нужно тщательно выбирать метод. Например, в ситуации, когда доступность имеет решающее значение, такой как портал фондовой биржи, обработка транзакций должна быть предпочтительным методом.

Важно отметить разницу между обработкой данных и системой обработки данных.Обработка данных — это правила, по которым данные преобразуются в полезную информацию. Система обработки данных — это приложение, оптимизированное для определенного типа обработки данных. Например, система с разделением времени предназначена для оптимального выполнения обработки с разделением времени. Его также можно использовать для выполнения пакетной обработки. Однако он не очень хорошо масштабируется для работы.

Его также можно использовать для выполнения пакетной обработки. Однако он не очень хорошо масштабируется для работы.

В этом смысле, когда мы говорим о выборе правильного типа обработки данных для ваших нужд, мы имеем в виду выбор правильной системы.Ниже приведены наиболее распространенные типы обработки данных и их применения.

1. Обработка транзакцийОбработка транзакций развертывается в критически важных ситуациях. Это ситуации, которые в случае нарушения могут отрицательно повлиять на бизнес-операции. Например, обработка биржевых операций, как упоминалось ранее. При обработке транзакций доступность является наиболее важным фактором. На доступность могут влиять такие факторы, как:

- Оборудование: Система обработки транзакций должна иметь избыточное оборудование.Аппаратное резервирование допускает частичные отказы, поскольку резервные компоненты могут быть автоматизированы, чтобы взять на себя управление и поддерживать работу системы.

- Программное обеспечение: Программное обеспечение системы обработки транзакций должно быть спроектировано так, чтобы быстро восстанавливаться после сбоя. Обычно системы обработки транзакций используют для этого абстракцию транзакций. Проще говоря, в случае сбоя незавершенные транзакции прерываются. Это позволяет системе быстро перезагружаться.

Очень часто наборы данных слишком велики, чтобы поместиться на одной машине. Распределенная обработка данных разбивает эти большие наборы данных и сохраняет их на нескольких машинах или серверах. Он основан на распределенной файловой системе Hadoop (HDFS). Система распределенной обработки данных отличается высокой отказоустойчивостью. Если один сервер в сети выходит из строя, задачи обработки данных могут быть перенесены на другие доступные серверы.

Распределенная обработка также может быть очень экономичной.Компаниям больше не нужно строить дорогие мэйнфреймы и вкладывать средства в их содержание и обслуживание.

Потоковая обработка и пакетная обработка являются распространенными примерами распределенной обработки, обе из которых обсуждаются ниже.

Вам нравится эта статья?

Получайте отличный контент еженедельно с новостной рассылкой Xplenty!

3. Обработка в реальном времениОбработка в реальном времени похожа на обработку транзакций в том, что она используется в ситуациях, когда ожидается вывод в реальном времени.Однако они отличаются тем, как они справляются с потерей данных. При обработке в реальном времени поступающие данные вычисляются максимально быстро. Если он обнаруживает ошибку во входящих данных, он игнорирует ошибку и переходит к следующему блоку входящих данных. Приложения GPS-слежения являются наиболее распространенным примером обработки данных в реальном времени.

Сравните это с обработкой транзакций. В случае ошибки, например сбоя системы, обработка транзакции прерывает текущую обработку и выполняет повторную инициализацию. Обработка в реальном времени предпочтительнее обработки транзакций в случаях, когда достаточно приблизительных ответов.

В мире аналитики данных потоковая обработка — это обычное применение обработки данных в реальном времени. Впервые популяризированная Apache Storm, потоковая обработка анализирует данные по мере их поступления. Считайте данные с датчиков Интернета вещей или отслеживание активности потребителей в режиме реального времени. Google BigQuery и Snowflake — это примеры платформ облачных данных, которые используют обработку в реальном времени.

4. Пакетная обработкаКак следует из названия, пакетная обработка — это когда блоки данных, хранящиеся в течение определенного периода времени, анализируются вместе или группами.Пакетная обработка требуется, когда для получения подробной информации необходимо проанализировать большой объем данных. Например, данные о продажах компании за определенный период времени обычно проходят пакетную обработку. Поскольку задействован большой объем данных, системе потребуется время для его обработки. Пакетная обработка данных позволяет сэкономить вычислительные ресурсы.

Пакетная обработка предпочтительнее обработки в реальном времени, когда точность важнее скорости. Кроме того, эффективность пакетной обработки также измеряется с точки зрения пропускной способности.Пропускная способность — это количество данных, обрабатываемых за единицу времени.

5. МногопроцессорностьМногопроцессорность — это метод обработки данных, при котором два или более чем два процессора работают с одним и тем же набором данных. Это может звучать в точности как распределенная обработка, но есть разница. При многопроцессорности разные процессоры находятся в одной системе. Таким образом, они находятся в одном географическом месте. Если произойдет сбой компонента, это может снизить скорость системы.

Распределенная обработка, с другой стороны, использует серверы, которые независимы друг от друга и могут находиться в разных географических точках. Поскольку сегодня почти все системы имеют возможность обрабатывать данные параллельно, почти каждая система обработки данных использует многопроцессорность.

Однако в контексте этой статьи многопроцессорность можно рассматривать как наличие локальной системы обработки данных. Как правило, компании, которые обрабатывают очень конфиденциальную информацию, могут выбрать локальную обработку данных, а не распределенную.Например, фармацевтические компании или предприятия, работающие в нефтегазодобывающей отрасли.

Самым очевидным недостатком такой обработки данных является стоимость. Строительство и обслуживание собственных серверов обходятся очень дорого.

Кейт подключил несколько источников данных к Amazon Redshift для преобразования, организации и анализа данных о клиентах. MongoDB Amazon Redshift

Дэйв Шуман

Технический директор и соучредитель Raise.мне

Они действительно предоставили интерфейс в этот мир преобразования данных, который работает. Это интуитивно понятно, с ним легко справиться […], и когда это становится для нас слишком запутанным, [служба поддержки клиентов Xplenty] иногда работает целый день, просто пытаясь помочь нам решить нашу проблему, и никогда не сдавайся, пока не решишь.

УЗНАЙ, МОЖЕМ ЛИ МЫ ИНТЕГРИРОВАТЬ ВАШИ ДАННЫЕКОМПАНИИ ПО ВСЕМУ МИРУ ДОВЕРЯЮТ

Вам нравится эта статья?

Получайте отличный контент еженедельно с новостной рассылкой Xplenty!

Подготовка данных к обработке

Прежде чем данные можно будет обработать и проанализировать, их необходимо подготовить, чтобы они могли быть прочитаны алгоритмами.Необработанные данные должны пройти ETL — извлечь, преобразовать, загрузить — чтобы попасть в ваше хранилище данных для обработки. Xplenty упрощает задачу подготовки ваших данных для анализа. С нашей облачной платформой вы можете создавать конвейеры данных ETL за считанные минуты. Простой графический интерфейс избавляет от необходимости писать сложный код. Прямо из коробки имеется поддержка интеграции для более чем 100 популярных хранилищ данных и приложений SaaS. И вы можете использовать API для быстрой настройки и гибкости.

С Xplenty вы можете тратить меньше времени на обработку ваших данных, поэтому у вас будет больше времени на их анализ.Узнайте больше, запланировав демонстрацию и испытав нашу платформу с низким кодом на себе.

ОБРАБОТКА ДАННЫХ НА КОМПЬЮТЕРЕ

ВведениеОбработка данных относится к преобразованию необработанных данных в осмысленный вывод.

Данные могут быть выполнены вручную с помощью ручки и бумаги, механически с помощью простых устройств, например, пишущей машинки или в электронном виде с использованием современных инструментов обработки данныхseg компьютеров